AI 的未来:去中心化人工智能

来源:AI 的未来:去中心化人工智能

原文标题:《AI in Web3: Navigating AI’s Future with Web3》

撰文:DWF Labs Research

编译:Carl,Techub News

在过去的一年里,OpenAI 推出的 ChatGPT 3.5 让人工智能成为讨论的焦点,ChatGPT 展示出了人工智能巨大的经济潜力,同时也引发了全球对其带来的影响和风险等方面的讨论。

随着乐观情绪的增长,怀疑也随之而来。潜在的后果开始给监管机构敲响警钟。人工智能的迅速崛起和模糊的监管框架,与处于早期的加密货币领域相呼应。两个行业似乎就像两条平行线一样,去中心化的 Web3 与人工智能潜在的中心化力量形成互补。在今年的第一季度里,几乎所有 Web3 VC 都在讨论人工智能的变革潜力(有一次,我都在疑惑自己参加的活动主题到底是 Web3 还是 AI)。在这一年中,我们还看到一些风险投资机构转向 AI 或将其纳入其投资任务。

来源:web3 VC space

现在,随着时间的推移,对 AI 的炒作逐渐消退,DWF Ventures 希望以公正的视角来重新审视人工智能领域。本文概述了人工智能的演变以及它如何达到目前的流行程度。然而,本文的叙述有一个明显的不同:将从普遍关注的人工智能如何影响 Web3 转向探索相反的方向——Web3 如何影响人工智能。在本文中,我们深入研究了去中心化和 Web3 如何充当催化剂,解决人工智能当前面临的挑战。

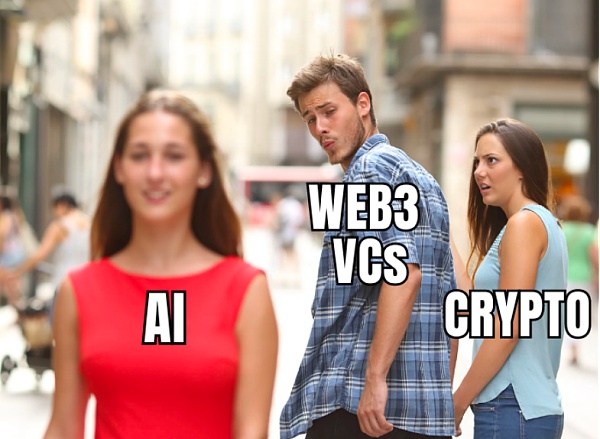

AI 发展史和 ChatGPT 的突破

资料来源:(Khan、Pasha & Masud,2021)

人工智能的历史可以追溯到 20 世纪 30 年代。1950 年代的图灵机,包括图灵测试,正式奠定了人工智能的基础。尽管早期很乐观,但由于计算障碍和无法满足实时需求,人们在 20 世纪 70 年代对人工智能的热情有所下降,迎来了「人工智能冬天」。20 世纪 80 年代,专家系统利用知识数据库模拟人类专业知识,又一次重振了人工智能,并出现了联结主义的复兴和循环神经网络的兴起。

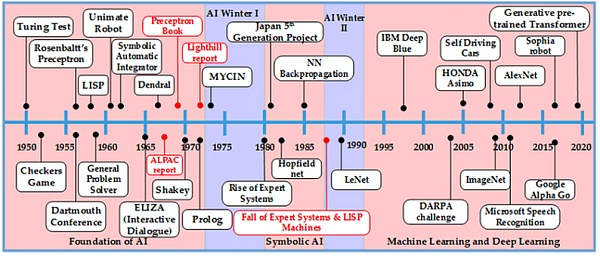

然而,专家系统在知识获取和实时分析方面遇到了挑战,这导致人工智能在 20 世纪 90 年代又一次衰落。此后经过多年的发展,人工智能领域取得了很大的进展,已扩展到机器学习、自然语言处理、计算机视觉、语音识别等不同的技术领域。这些发展使得人工智能从简单的解决问题发展到复杂应用领域的深度学习。

资料来源:Mukhamediev et al.,2022

在发展过程中,我们看到了人工智能各个子领域的融合。在这些领域中,机器学习和大语言模型(LLM)领域取得了重大进展。Ashish Vaswani 等人的论文启发了基于 transformer 的生成式预训练模型(GPT)。此后,大量的 GPT 出现,例如「BERT」GPT 和 OpenAI 团队的GPT。ChatGPT 之后,还出现了 Falcon 和 LLaMA2 等开源替代方案,加剧了开发更接近 AGI(通用人工智能)的下一代 GPT 的竞争。

GPT 的炒作帮助 AI 从学术界进入了数十亿人的视野。ChatGPT 发布后 2 个月内,创下了每周活跃用户数超过 1 亿的最快记录。麦肯锡最近的一项研究显示,目前,科技行业约 51% 的专业人士在工作中使用 AI。

人工智能的社会认知和限制

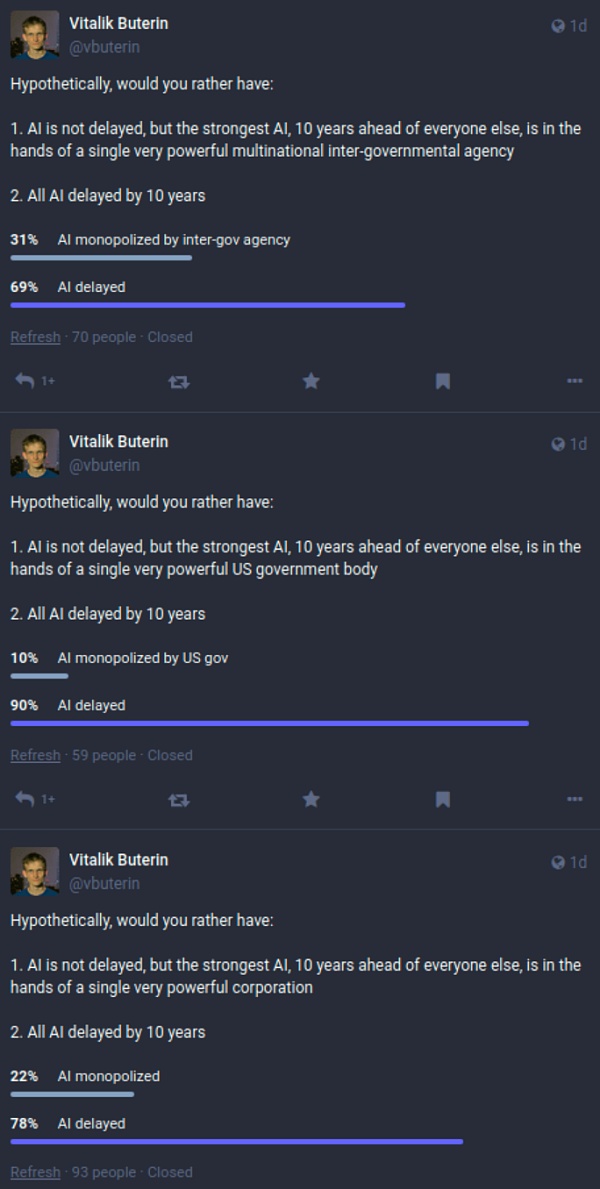

Vitalik 最近进行的一项民意调查显示,人们担心出现 AI 垄断版本,普遍倾向于推迟 AI 进步。

资料来源:My techno-optimism

ChatGPT 让 AI 受到的关注度激增,然而,大多数人没有意识到,虽然 GPT 模仿了人类交互,但它还不是 AGI。

GPT 每次在输出时,都会发生统计上的偏差,无法保证一致性和事实准确性。GPT 还面临其他限制,其最突出的缺点是无法进行逻辑推理,尤其是在数学方面。

GPT 的局限性

描述

文本合成的局限性

- 文档级的语义重复

- 长段落中的连贯性

- 自相矛盾和不合逻辑的句子

无法完成离散语言任务

- 不符合“物理常识”

- 在比较单词用法和确定句子的含义等方面存在困难

结构和算法限制

- 在特定情境下的学习表现差

- 在“比较”任务上表现差

缺乏双向架构

- 缺乏双向架构和其他训练目标,可能会影响任务效果

预训练目标的局限性

- 在不考虑 Token 重要性的情况下,自我监督的预测可能会达到极限

样本预训练效率低下

- 与人类成长相比,大模型预训练的效率极低

小样本学习中的歧义

- 小样本学习是否在推理时“从头开始”学习新任务,还是识别预训练期间学到的任务方面存在模糊性

不切实际的模型规模和推理

- 像 GPT-3 这样的大模型价格昂贵且不方便使用

大模型的潜在滥用

- 在错误信息、垃圾邮件、网络钓鱼等活动中可能被滥用

由于投入巨大而缺乏公平性或导致偏见

- 训练数据中的偏差可能会导致大模型生成的内容强化刻板印象或偏见

高能源消耗

- 大规模预训练是能源密集型的,需要大量的计算资源

资料来源:Limitations of GPT in Language Models are Few-Shot Learners

鉴于围绕人工智能的无数担忧和有效管理大型人工智能模型的挑战,Web3 成为缓解这些挑战的潜在途径。Web3 固有的去中心化和分布式原则,有助于解决人工智能系统当前面临的问题。

去中心化人工智能

人工智能功能集中在中心化系统中,引起了人们对数据访问、模型关联性和整体可持续性的担忧。中心化人工智能系统面临重大障碍,特别是对于具有排他性的专有大型数据集。

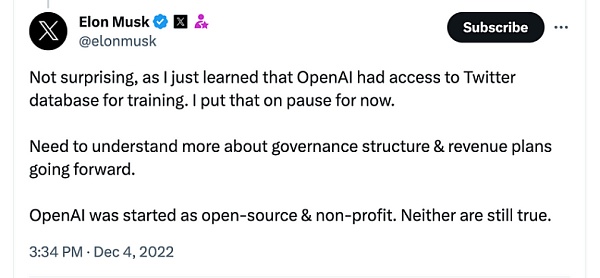

如上图,马斯克在 X 上表示:「这并不奇怪,因为我刚刚得知 OpenAl 可以访问 Twitter 数据库进行训练。我暂停了它。需要更多地了解未来的治理结构和收入计划。OpenAl 最初是开源和非营利性的,现在来看两者都不是。」

此后,X.com 开始对查询数据收费,并限制了用户的每日帖子浏览量。不久后,X.com 的 GPT「Grok」发布,允许用户实时访问 X.com 的数据。这形成了经济屏障,并引出人工智能的可访问性和包容性问题。

此外,如果没有持续的数据更新,已发布的大模型很快会过时,这对保持实用性和准确性构成了巨大的挑战。目前,ChatGPT 3.5 的训练数据是截至 2022 年 1 月的信息,而 Llama 2 则是在 2023 年 1 月至 2023 年 7 月之间。

为了应对这些挑战,去中心化人工智能(DAI) 成为一种有前途的范例,为中心化的局限性提供了潜在的解决方案。

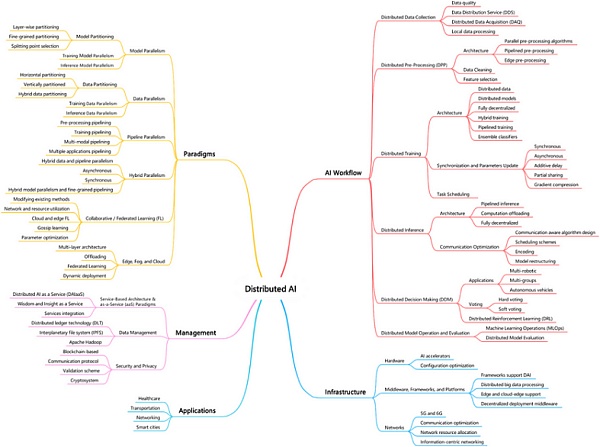

资料来源:(Janbi 等人,2023)

DAI 提供了一种替代路径,以应对中心化模型固有的挑战。Janbi 等人最近的一篇论文进行了全面的分析,并将 DAI 分为以下五个主要领域。

领域

描述

Web3 的影响

人工智能工作流程

大模型的系统化开发与训练

DAI 简化了这一过程并使之民主化,使其更易于访问和协作。

人工智能基础设施

科技基础设施,包括硬件、软件和网络。

去中心化物理基础设施网络(DePIN) 可以为计算资源提供更有效的路径。

范式

指导人工智能系统设计和实施的框架

引入新的范式,例如协作或联合学习,使计算更加贴近用户。

管理

确保有效资源分配和项目协调的机制

需要引入众多复杂的利益相关者,形成创新的协调和激励机制。

应用领域

为用户量身定制的人工智能技术应用。

利用去中心化提高效率、透明度和道德规范。

资料来源:(Janbi 等人,2023)+ DWF Ventures

DAI 的挑战

DAI 为人工智能带来了令人兴奋的转变和众多优势,然而,承认仍然存在的挑战至关重要。

好处

挑战

解决方案的多样性

不同专家系统之间的协作,每个专家系统都贡献独特的专业知识来解决超出个人能力的复杂问题

协调性差

确保利益相关者一致和合作具有挑战性,因为每个人都可能在知识不完整的情况下进行操作,从而导致潜在的不一致

模块化、可重复使用和高效率

模块化设计允许在各种应用程序中重复使用小型专家系统,通过专用处理器并行执行任务来提高效率

利益相关者知识不完整和不一致

分布式责任导致利益相关者只拥有部分知识,这可能会导致大家不一致,从而影响整个系统的可靠性

复杂性控制与对分布式问题的适应

分解处理分布式系统的任务

战略规划挑战

不同利益相关者难以就特定目标达成一致

无集中攻击点

通过避免中心化瓶颈的方式来增强响应能力,在数据或系统出现问题时弱化故障

信息收集的复杂性

由于无休止的沟通和动态变化,利益相关者必须决定如何以及何时更新其状态。

处理大规模问题

有潜力解决中心化系统无法解决的大规模问题。

资料来源:(Eduardo, L., & Hern, C.,1988) + DWF Ventures

结论

总之,DAI 正以巨大的潜力展开。由于供应商和用户有限,开源替代方案面临困难,而 ChatGPT API 为大众市场提供了实用且经济的选择,提供了易用性和可靠性。

然而,考虑到垄断的通用人工智能的潜在后果,个人应该重新权衡其选择和行动中的便利性和去中心化。在更广泛的范围内,Web3 和 AI 社区的创新者可以重新定义 AI 工作流程、重新构建基础设施、采用创新范式、高效管理以及开发符合去中心化原则的应用程序来应对挑战。当我们继续沿着这条道路前进时,协作、包容性和道德规范将成为塑造真正造福人类的 DAI 格局的关键。

来源:金色财经

交易商排行

更多- 监管中EXNESS10-15年 | 英国监管 | 塞浦路斯监管 | 南非监管88.77

- 监管中FXTM 富拓10-15年 |塞浦路斯监管 | 英国监管 | 毛里求斯监管85.36

- 监管中GoldenGroup高地集团澳大利亚| 5-10年85.87

- 监管中金点国际集团 GD International Group澳大利亚| 1-2年86.64

- 监管中Moneta Markets亿汇澳大利亚| 2-5年| 零售外汇牌照80.52

- 监管中IC Markets10-15年 | 澳大利亚监管 | 塞浦路斯监管91.71

- 监管中CPT Markets Limited5-10年 | 英国监管 | 伯利兹监管91.56

- 监管中GO Markets高汇15-20年 | 澳大利亚监管 | 塞浦路斯监管 | 塞舌尔监管87.90

- 监管中alpari艾福瑞5-10年 | 白俄罗斯监管 | 零售外汇牌照87.05

- 监管中AUS Global5-10年 | 塞浦路斯监管 | 澳大利亚监管86.47